La puissance à son sommet – les Etats-Unis – est hantée par sa responsabilité. Ce qu’elle construit n’est-il pas au détriment du monde naturel voulu par Dieu ? L’orgueil humain n’a-t-il pas la tentation de rebâtir encore et toujours des tours de Babel ?

Arpanet, le précurseur savant d’Internet, débute tout juste comme expérience à la fin des années soixante lorsque le roman Colossus d’où est issu le film est écrit. Le film personnalise le projet du nom du savant fou, qui se croit trop rationnel pour échouer : le docteur Forbin (Eric Braeden). Celui-ci construit un ordinateur géant sous les montagnes Rocheuses, alimenté par un réacteur nucléaire indépendant. Il a pour but le militaire : mettre hors de toute émotion ou défaillance humaine le système de défense balistique des Etats-Unis.

Le président insignifiant de la première puissance de la planète (Gordon Pinsent) annonce devant la presse mondiale le Projet. Il apparaît comme un anti-Nixon (le président américain qui vient d’être élu en vrai) et ne ressemble pas vraiment à Kennedy, bien qu’on l’air dit. Il clame au monde que le monde devient plus sûr grâce à l’avance technologique des Etats-Unis… C’est à ce moment que l’ordinateur géant, baptisé Colossus, envoie tranquillement un message disant qu’il n’est pas seul. Et l’URSS avoue : elle aussi a bâti un système équivalent, Guardian, par mimétisme et espionnage comme il se doit. Un partout ?

Non pas ! Les deux systèmes exigent d’être mis en connexion « pour la paix du monde » – ce qui est renvoyer les humains à leur hypocrisie, les mots voulant vraiment dire ce qu’ils veulent dire dans la logique binaire d’un ordinateur. Le contraire même de « la guerre c’est la paix » vilipendé par Orwell dans 1984. Nous sommes loin de la post-vérité et autres mensonges déconcertants qui règnent en politique ! L’ordinateur a été programmé pour qu’un mot ait un sens – et il l’applique, malgré les arrière-pensées, les sous-entendus et les émotions trop humaines.

Colossus et Guardian communiquent par formules mathématiques de plus en plus complexes, jusqu’à ce que leur signification, trop avancée pour la recherche, échappe aux informaticiens chevronnés qui les suivent sur imprimante. Le système interconnecté va-t-il décider seul, sans contrôle humain ? Les présidents américain et russe en liaison vidéo résistent : ils coupent la liaison. Mais Colossus ne se démonte pas, il exige qu’elle soit rétablie. Sinon ? Eh bien l’homme ne sera plus le maître de la machine, le fils se révoltera contre le père, et les systèmes reliés vont chacun envoyer un missile sur une base de l’autre. Ce qui est fait. Les présidents sont obligés de plier et de rétropédaler.

Mais le système soviétique, trop lent, ne peut intercepter le missile américain et celui-ci raye de la carte un centre pétrolier et la ville d’à côté. Le Texas, lui, visé par le missile soviétique, est sauvé. Premiers morts dus aux machines.

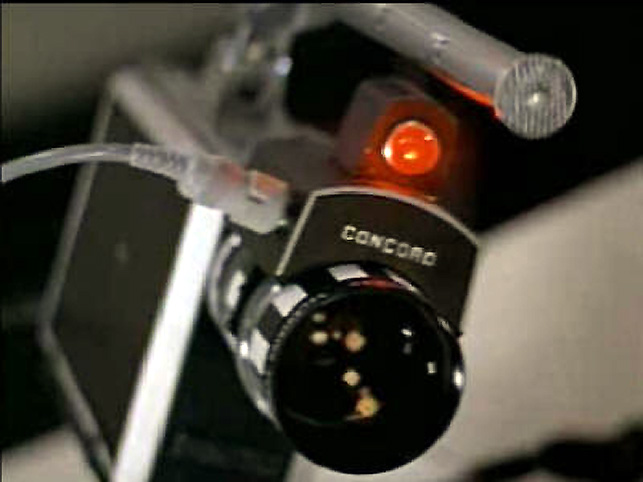

Les deux inventeurs, l’Américain et le Russe, se rencontrent secrètement à Rome, hors des oreilles du Big Système – croient-ils. Mais les machines interconnectent tous les réseaux, comme le Big Brother d’Orwell et le Google d’aujourd’hui, et elles sont au courant. Puisque les humains deviennent des gêneurs, il faut les dompter. Le docteur russe Kuprin (Alex Rodin) est éliminé par ordre suprême, imprimé et livré avec tous les codes d’authentification par le double système Colossus-Guardian : il ne sert plus à rien à la Machine. Le docteur américain Forbin est mis sous surveillance jour et nuit par caméras et micros. Forbin négocie in extremis quatre nuits par semaine d’intimité avec sa « maitresse », un autre docteur informatique (Susan Clark), pour passer des messages en douce et collecter de l’information afin de contrer l’ordinateur. Logique, celui-ci accepte formellement de respecter le sens du mot intimité (privacy).

Mais l’humain peut-il faire confiance à la machine ? Celle-ci n’est qu’une mécanique logique, elle ne connait pas le sens de l’honneur ni le respect des engagements ; elle fait ce qu’elle est programmée à faire, préserver la paix mondiale par tous les moyens. La caméra et le micro, en apparence désactivés la nuit, sont toujours là : écoutent-ils comme nos micros et caméras de smartphones et portables (même éteints) peuvent le faire si un opérateur le décide ? Ce n’est pas dit, mais soupçonné… D’ailleurs, Colossus a compris qu’on cherche à le déconnecter et il décide de donner une nouvelle leçon : puisque la raison ne suffit pas, la peur est de rigueur : paf ! deux missiles à tête nucléaire vitrifient deux villes de la carte, aux Etats-Unis même. Des millions de gens sont morts pour assurer à ceux qui restent la paix définitive.

Le docteur est prisonnier de sa créature, il ne peut qu’obéir. Le Système est désormais le maître du monde, jusqu’à ce que l’énergie de son réacteur s’épuise (mais il va sûrement y remédier !). Il assure que la guerre comme la surpopulation, la famine comme l’obésité, seront abolis, que le travail comme les loisirs seront assurés à tous en proportion raisonnable et rationnée afin de vivre longtemps. Un vrai socialisme réalisé, avec Plan neutre de gestion de la planète. Et les humains béniront la machine, ce nouveau Dieu qu’ils finiront par aimer et peut-être adorer. Devenu Père et Seigneur à la fois, il les guidera par force dans la voie de la raison et contiendra leurs passions comme un shérif.

Le vieux rêve chrétien de Cité de Dieu – ou de société communiste – est enfin réalisé, au détriment de la liberté. Mais la liberté n’est-elle pas la tentation du diable ? Laisser faire, n’est-ce pas inciter à pécher ? Avoir à sa disposition tous les possibles n’est-ce pas une illusion ? Chaque humain est programmé par ce qu’il est, la façon dont il a été éduqué et la société dans laquelle in vit : où est donc sa liberté ? Le message – logique – de l’ordinateur rejoint le marxisme anti-système comme l’hégélianisme issu du modèle catholique romain. Subversif, le film conteste l’essence même des Etats-Unis : le pionnier individualiste qui se fait tout seul (self-made man), le laisser-faire des instincts et passions (capitalisme), la liberté de vouloir toujours être plus et gagner (complexe militaro-industriel).

Par son orgueil, l’humanité a sauté au-delà de sa condition pour créer un monstre. Non pas un sur-humain mais un post-humain, créant non pas un transhumanisme mais un pur machinisme. Cette fois, contrairement à l’ordinateur embarqué HAL de Stanley Kubrick (dont le film est sorti trois ans avant), la machine a gagné ! C’était en 1970.

DVD Le cerveau d’acier de Joseph Sargent (Colossus, The Forbin Project), 1970, avec Eric Braeden, Susan Clark, Gordon Pinsent, William Schallert, Leonid Rostoff, Movinside 2017, €18.84

Commentaires récents